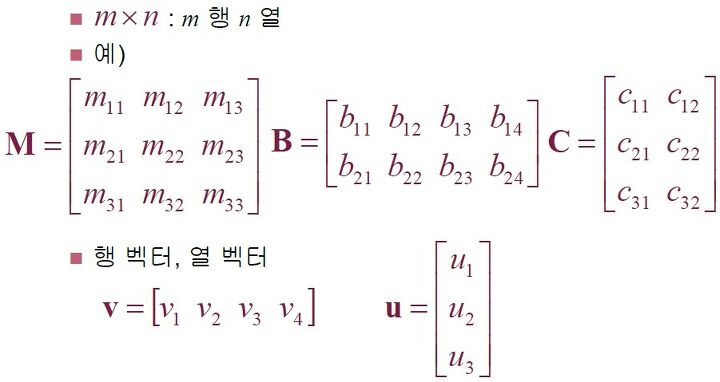

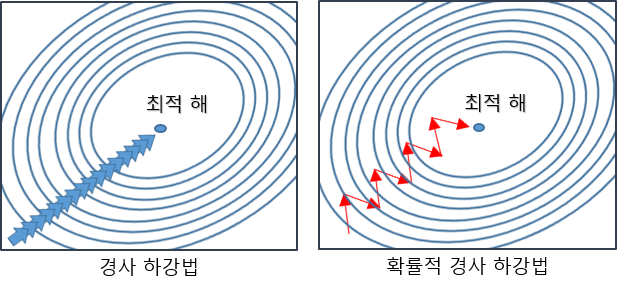

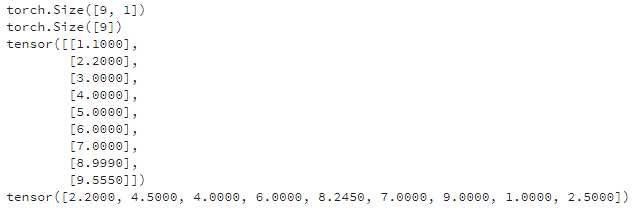

참고 자료[1] Pytorch로 시작하는 딥러닝, 비슈누 수브라마니안 지음, 김태완 옮김 딥러닝 학습과정 선형 레이어선형 레이어는 여러가지 이름으로 불린다. 다른 프레임워크에서는 덴스 레이어(dense Layer) 또는 연결 레이어(Fully Connected Layer)라고 부르기도 한다. 다수의 복수 레이어를 사용한다는 개념은 각 레이어 마다 입력 데이터의 패턴을 학습하고, 다음 레이어는 앞에서 학습한 패턴을 기반으로 학습을 이어나간다는 것이다. 그러나, 단순히 선형 레이어를 연속으로 여러 개 쌓게 되면 1개 선형 레이어로 간단하게 표현된 학습 결과와 같다. Y = 2(3X) - 2개의 선형 레이어Y = 6(X) - 1개의 선형 레이어 이러한 문제를 해결하기 위해, 여러 비선형 함수를 사용하게 되며 ..